Avec Magento système de magasin, vous pouvez rapidement et facilement créer de nombreux magasins individuels et indépendants, tous un aspect différent, offrir d'autres produits, avoir d'autres prix et surtout sous leurs propres domaines sont accessibles.

Mais ce que l'optimisation des moteurs de recherche pour Google, Bing etc. à partir de, si vous avez plusieurs magasins? Depuis qu'un système de fichiers commun utilisé, vous devez employer quelques trucs ici.

- Dans chaque cas, créer un sitemap.xml par magasin:

Magento peut par défaut sitemap.xml que la création de la. Il n'existe pas de (standard) Cette possibilité de renommer (plus d'info ICI). Bien sûr, il existe des extensions pour, qui les tâches rapidement et confortablement, Mais il est une autre façon.

On peut chaque sitemap.xml mais mettre dans des dossiers différents.

Ainsi, nous plaçons dans le répertoire racine Magento un répertoire par magasin à déguster:

– sitemap-shop1

– sitemap-shop2

– sitemap-Shop3

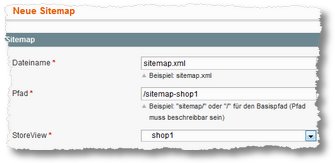

Ensuite, nous allons dans le backend de Magento au catalogue > Google Sitemap.

Il nous cliquez sur “Ajouter Plan du site”, donner comme Nom sitemap.xml, puis saisissez le chemin et ensuite chercher la vue magasin correspondant de. Puis sur “Sauver & Dresser” cliquez.

Le plan du site a été créé et devrait regarder mieux-- sont dans le bon dossier. - Configurer, que les sitemaps sont automatiquement mises à jour:

Pour mettre à jour automatiquement les Sitemaps Magento (doit Magento Cron être activé sur le côté serveur!), homme homme sous Système > Configuration > Catalogue / Google Sitemap et y aller pour déposer le Plan du site, par exemple. est créé quotidien. - Régler, que Google et autres robots seront également trouver le bon plan du site = le fichier robots.txt appropriée créer

Maintenant un problème général(chen). Normalement vous ne crée également un fichier robots.txt pour une page. Google und Co. Attendez-vous donc ce robots.txt (même s'ils ne doit pas nécessairement). Pour un multi-boutique nous avions besoin, mais à proprement parler plusieurs robots.txt, l'u.a. dire où le plan du site est. Par conséquent, nous créons par exemple.

– robots-shop1.txt

– robots-shop2.txt

– robots-shop3.txt

Dans ces fichiers, nous stockons sur un côté, par exemple,. une partie standard, ou de garder les moteurs de recherche à partir de certaines pages:User-agent: * Interdire: /index.php/ Disallow: /*? Interdire: /*.js$ Disallow: /*.css$ Disallow: /*.php$ Disallow: /admin/ Disallow: /app/ Disallow: /catalog/ Disallow: /catalogsearch/ Disallow: /checkout/ Disallow: /customer/ Disallow: /downloader/ Disallow: /js/ Disallow: /lib/ Disallow: /media/ Disallow: /newsletter/ Disallow: /pkginfo/ Disallow: /report/ Disallow: /review/ Disallow: /skin/ Disallow: /var/ Disallow: /envies /

et ajouter la dernière ligne

Plan du site: http://www.shop1.de/shop1/sitemap.xml

en outre. Nous le faisons pour tous les magasins et changeons chaque ci-dessous le nom de domaine, indiquant l'emplacement respectif de la sitemap.xml. Donc, nous avons donc après trois fichiers robots, le tout dans le répertoire racine Magento.

Il manque encore une dernière étape. - À propos de l'. Htacces définissant robots est responsable de quel domaine:

Pour cela, nous ouvrons le. Htaccess dans le répertoire racine de magenta et d'ajouter à la fin les lignes suivantes## Qu'est-ce que les robots pour lesquels domaine ## RewriteCond %{HTTP_HOST} ^ *.?shop1 . $ de [Caroline du Nord] RewriteRule ^robots\.txt$ robots.shop1.txt RewriteCond %{HTTP_HOST} ^ *.?shop2 . $ de [Caroline du Nord] RewriteRule ^robots\.txt$ robots.shop2.txt RewriteCond %{HTTP_HOST} ^ *.?Shop3 . $ de [Caroline du Nord] RewriteRule ^ robots . Txt $ robots.shop3.txt

Cela devrait fonctionner maintenant tout. Les bots sont à la page, voir à ce sujet. htaccess, qu'ils doivent respecter les robots respectifs, il s'agit des sitemaps dans les sous-répertoires et ainsi est magnifiquement indexé et réparti entre les magasins et les domaines respectifs de multistores.

Utilisé dans la version Magento 1.8.1.0 Remarques? Ajouts? Remarques? Volontiers!

Si vous voulez reproduire le problème sur les extensions: http://store.cueblocks.com/xml-sitemap-plus-generator-splitter.html et http://store.cueblocks.com/cueblocks-robots-txt.html Il est recommandé.

Google conseille la manière de celui-ci de JS et CSS exclu.

(voir. http://googlewebmastercentral.blogspot.de/2014/05/rendering-pages-with-fetch-as-google.html)

En outre, l'affectation des sitemaps à un multi-porte peut être proprement mappé via le htaccess, de sorte que la /sitemap.xml approprié est toujours fourni.

(voir. http://oldwildissue.wordpress.com/2012/02/27/magento-google-sitemap-generation-for-multistore-installation/)

Désolé, vous devez alors fournir également robots.txt différente, de

Sitemap:un “plein” URL est requis.(voir. http://www.sitemaps.org/protocol.html#submit_robots)

Mais l'effort en vaut la peine, dans le piège toutes les demandes de /sitemap.xml et vous épargner des extensions supplémentaires.

Salutation