Con el sistema de la tienda Magento, puede crear rápida y fácilmente muchas tiendas individuales e independientes, todos se ven diferente, ofrecer otros productos, tener otros precios y sobre todo en virtud de sus propios dominios son accesibles.

Pero lo que con la optimización del Search Engine para Google, Bing, etc. de, si tiene varias tiendas? Dado que sólo un sistema de archivos común que se utiliza, la necesidad de emplear algunos trucos aquí.

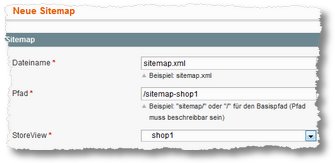

- En cada caso, cree un sitemap.xml por Tienda:

Magento puede predeterminados sitemap.xml sólo la creación de la. No hay (estándar) Esta posibilidad de cambiar el nombre (más información AQUÍ). Seguro que hay extensiones para, que las tareas de forma rápida y cómoda, Pero hay otra manera.

Uno puede cada sitemap.xml pero puso en carpetas diferentes.

Por lo tanto, colocamos en el directorio raíz de Magento un directorio por tienda a probar:

– Mapa del sitio-shop1

– Mapa del sitio-shop2

– Mapa del sitio-shop3

Luego nos vamos en el backend de Magento para catalogar > Google Sitemap.

No hacemos clic en “Añadir Sitemap”, dar como Nombre sitemap.xml, a continuación, introduzca la ruta y luego buscar la opinión de tienda correspondiente de. Luego, el “ALMACENAR & LEVANTAR” HACER CLIC.

El mapa ha sido creado y debería mejor look-- se encuentran en la carpeta correcta. - Configurar, que los mapas de sitio se actualizan automáticamente:

Para actualizar automáticamente los sitemaps de Magento (Tienes que habilitar el Magento Cron en el lado del servidor!), man man en Sistema > Configuración > Catálogo / Google Sitemap y ir allí para depositar el Sitemap ejemplo. se crea todos los días. - Ajustar, que Google y otros robots también se encuentra el sitemap correcta = el robots.txt apropiado crear

Ahora, un problema general(chen). Normalmente también sólo crea un archivo robots.txt para una página. Google und Co. Así que esperamos que este robots.txt (incluso si ellos no necesariamente tienen). Para una multitienda que necesitábamos, pero estrictamente hablando varios robots.txt, la ü.A. decir dónde está el mapa del sitio es. Por lo tanto, creamos, por ejemplo,.

– robots-shop1.txt

– robots-shop2.txt

– robots-shop3.txt

En estos archivos almacenamos en un lado, por ejemplo,. una parte estándar, o para mantener a los motores de búsqueda de ciertas páginas:User-agent: * Rechazar: /index.php/ Rechazar: /*? Rechazar: /*.js$ Rechazar: /*.cs$ Rechazar: /*.php$ Rechazar: /administración/ Rechazar: /aplicación/ Rechazar: /catalogar/ Rechazar: /búsqueda de catálogo/ Rechazar: /verificar/ Rechazar: /cliente/ Rechazar: /descargador/ Rechazar: /js/ Rechazar: /biblioteca/ Rechazar: /medios de comunicación/ Rechazar: /Boletin informativo/ Rechazar: /paqueteinfo/ Rechazar: /informe/ Rechazar: /revisar/ Rechazar: /piel/ Rechazar: /var/ Rechazar: /Deseos /

y agregue como la última línea

Mapa del sitio: http://www.shop1.de/shop1/sitemap.xml

Además. Hacemos esto para todas las tiendas y cambiar cada uno a continuación del dominio, que indica la ubicación de la respectiva sitemap.xml. Así que tenemos así que después de tres archivos de Robots, todo ello en el directorio raíz de Magento.

Todavía le falta un último paso. - Sobre el. Htacces definir robots es responsable de qué dominio:

Para ello, abra el archivo. Htaccess en el directorio raíz de magenta y añadimos al final las siguientes líneas al## Lo robots para qué dominio ## RewriteCond %{HTTP_HOST} ^ *.?shop1 . de $ [NC] Reescribir regla ^robots.txt$ robots.shop1.txt ReescribirCond. %{HTTP_HOST} ^ *.?shop2 . de $ [NC] Reescribir regla ^robots.txt$ robots.shop2.txt ReescribirCond. %{HTTP_HOST} ^ *.?shop3 . de $ [NC] RewriteRule ^ robots . Txt $ robots.shop3.txt

Esto debería funcionar ahora todo. Los robots vienen a la página, ver en eso. htacces, que deben mantener a los respectivos robots, esto se refiere a los mapas de sitio en los subdirectorios y por lo tanto está muy bien indexado y asignado a las respectivas tiendas y dominios de multitiendas.

Se utiliza en la versión de Magento 1.8.1.0 Comentarios? Adiciones? Notas? Con alegría!

Wer das Thema über Extensions abbilden möchte: http://store.cueblocks.com/xml-sitemap-plus-generator-splitter.html Y http://store.cueblocks.com/cueblocks-robots-txt.html sei empfohlen.

Google rät übrigens davon ab JS und CSS auszusperren.

(vgl. http://googlewebmastercentral.blogspot.de/2014/05/rendering-pages-with-fetch-as-google.html)

Weiterhin lässt sich die Zuordnung der Sitemaps zu einem der Multistores sauber über die .htaccess abbilden, damit immer die passende /sitemap.xml ausgeliefert wird.

(vgl. http://oldwildissue.wordpress.com/2012/02/27/magento-google-sitemap-generation-for-multistore-installation/)

Leider muss man dann auch unterschiedliche robots.txt ausliefern, de

Sitemap:UNA “volle” URL benötigt.(vgl. http://www.sitemaps.org/protocol.html#submit_robots)

Aber der Aufwand lohnt sich wohl, im alle /sitemap.xml Anfragen abzufangen und sich zusätzliche Extensions zu sparen.

SALUDO